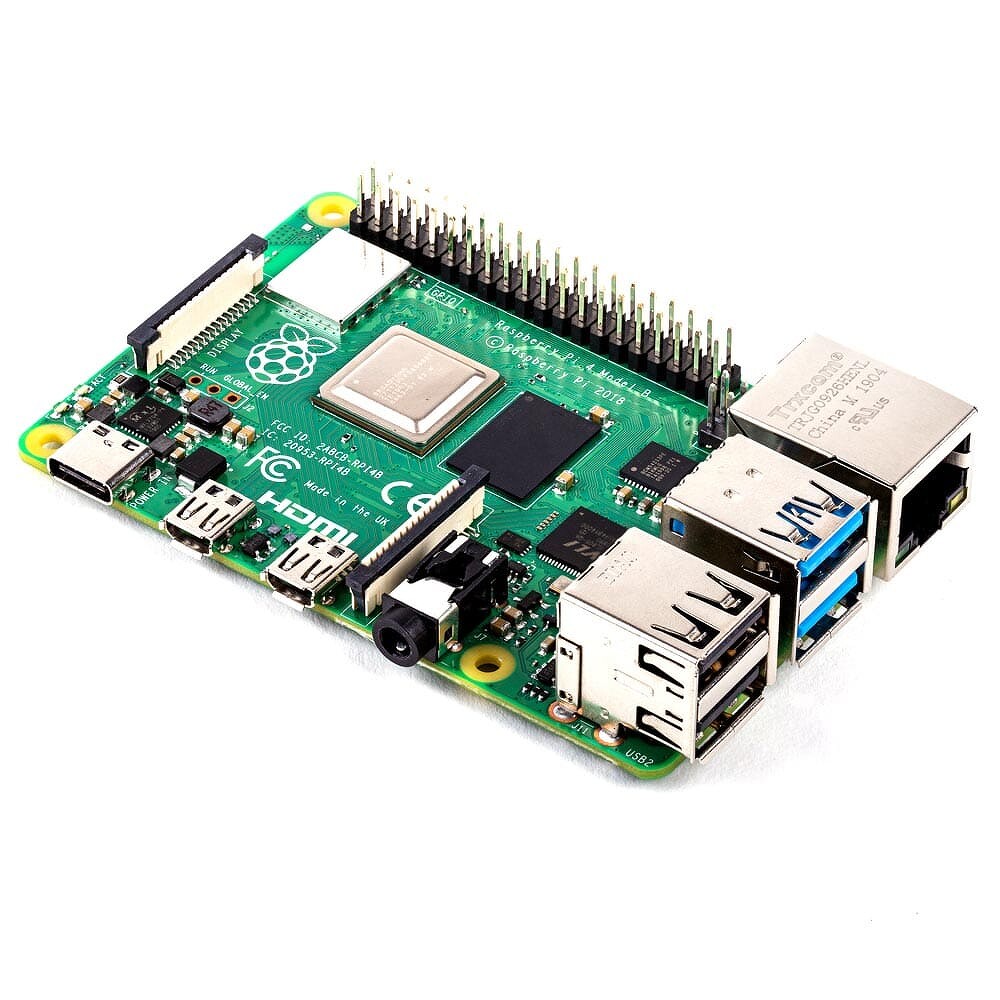

Microsoft опростоволосилась. Создан «полноценный конкурент» ChatGPT за $600. Он работает на Raspberry Pi

Создана нейросеть Alpaca 7B, не уступающая ChatGPT. Ее разработка обошлась всего в $600, ее код находится в открытом доступе, и любой желающий сможет настроить ее под свои задачи приблизительно за $100. Для запуска Alpaca 7B хватит мощностей одноплатного ПК Raspberry Pi.

Нейросеть вместо iPhone

Группа ученых из Стэнфордского университета (США) разработала уникальную нейросеть Alpaca 7B, потратив на нее намного меньше $1000 (77,2 тыс. руб. по курсу ЦБ на 21 марта 2023 г.). Как пишет портал New Atlas, даже несмотря на столь скромные инвестиции проект по своим возможностям практически не уступает разрекламированной ChatGPT, созданной компанией OpenAI.

При этом точный размер вложений в OpenAI не раскрывается. В списке инвесторов OpenAI числится корпорация Microsoft, которая не так давно «влила» в эту компанию $1 млрд, получив право использовать ChatGPT в своих программных продуктах.

Разработка Alpaca 7B обошлась ученым всего-навсего в $600 (46,3 тыс. руб.). Это ненамного дороже самого дешевого iPhone в современном модельном ряду Apple – за ультрабюджетный iPhone SE 2022 в версии на 256 ГБ она просит $576 (44,5 тыс. руб.).

При этом авторы Alpaca 7B утверждают, что даже $600 – слишком крупная сумма для такого проекта, поскольку, по их словам, если бы у них было время на оптимизацию процесса обучения нейросети, они могли бы потратить еще меньше.

Что еще важнее, теперь любой, кто захочет интегрировать Alpaca 7B в свой сервис, потратит на ее дополнительное обучение не более $100 (7720 руб.). Основной массив знаний по умолчанию встроен в эту нейросеть.

Дешевле и лучше

В своем нынешнем исполнении нейросеть Alpaca 7B во многих задачах проявляет себя как минимум не хуже нашумевшей ChatGPT, хотя последняя способна даже написать дипломную работу — такой прецедент создан в России. В основе Alpaca 7B используется языковая модель с открытым исходным кодом LLaMA 7B — самой маленькой и дешевой из нескольких доступных моделей LLaMA. Но на начальном этапе она сильно отставала ChatGPT, ведь на развитие последней было потрачено гигантское количество времени и человеко-часов.

Чтобы быстро и эффективно развить Alpaca 7B до уровня ChatGPT, авторы проекта пошли на хитрость — они почти полностью автоматизировали процесс обучения своей нейросети при помощи API-инструментов OpenAI. Реализация этого этапа, то есть начального обучения, обошлась в $500 (38,6 тыс. руб.), а еще $100 (7720 руб.) стоило дополнительное «образование», то есть более тонкая настройка языковой модели.

При этом никаких гигантских вычислительных мощностей, аренды суперкомпьютера или чего-то в этом духе не потребовалось — ученым хватило восьми самых обычных компьютеров, трех часов времени и видеоускорителей Nvidia Tesla A100 с 80 ГБ памяти, которые они, опять же, не покупали.

Завершив обучение Alpaca 7B, они провели сравнительное тестирование своего творения, оппонентом в котором выступила базовая языковая модель ChatGPT. Обе нейросети выполнили несколько заданий, и Alpaca 7B, стоившая на уровне китайского смартфона Xiaomi 13, одержала победу. «Мы были весьма удивлены этим результатом, учитывая небольшой размер модели и скромный объем данных для выполнения инструкций», — отметили авторы проекта.

Повторить сможет каждый

Создатели Alpaca 7B выложили весь объем данных, использовавшихся для первоначального обучения нейросети, в свободном доступе на GitHub, что позволит любому, кто захочет повторить их путь, сэкономить $500. Как пишет New Atlas, этим тут же воспользовалась другая группа разработчиков, сильно упростив второй этап обучения нейросети, который обошелся авторам в $100.

Они разместили на GitHub код, позволяющий запустить Alpaca 7B даже на Raspberry Pi – одноплатном компьютере, который в последний раз обновлялся в 2019 г. Аренда дорогих ускорителей Nvidia Tesla A100 тоже не потребуется, как и группы из восьми ПК — хватит одного компьютера с одной видеокартой потребительского уровня Nvidia GeForce RTX 4090. Обучение займет пять часов.

Что будет дальше

Феномен Alpaca 7B, собранной группой энтузиастов за $600, наличие всех исходных данных в открытом доступе и возможность запускать столь мощную нейросеть на морально устаревшем одноплатном компьютере — все это открывает весьма широкие перспективы для развития частных нейросетей, пишет New Atlas. По сути, теперь можно создавать неограниченное количество языковых моделей без многомиллиардных вложений.

Для компаний, занимающихся разработкой ИИ, как и для их инвесторов, это тревожный звоночек. Пример Alpaca 7B очень показателен — весь мир убедился, что вкладывать суммы с девятью нулями в подобные проекты теперь нецелесообразно. Частные компании, которым после релиза ChatGPT срочно потребовалась своя нейросеть с аналогичными возможностями, тоже, вероятно, пересмотрят объемы вложений в них. Как известно, аналоги ChatGPT в той или иной степени готовности есть у американских Amazon, Apple, Google, китайской Baidu и многих других ИТ-гигантов.

Поделиться

Поделиться